Qu'est ce qu'un LLM ou Large Language Model tel que celui de ChatGPT?

Comprendre les LLM : fonctionnement, utilité et cas d'usage

Introduction aux LLM

Les LLM, ou Large Langage Models, sont des modèles d'intelligence artificielle capables de conversation en langage humain. Ils représentent une avancée majeure dans le domaine de l'intelligence artificielle appliquée au langage naturel (Natural Language Processing ou NLP). Ces modèles révolutionnaires ont la capacité non seulement de comprendre mais aussi de générer du langage humain de manière remarquablement réaliste. Leur impact s'étend sur de nombreux secteurs, de la création de contenu à la traduction automatique en passant par l'analyse de données textuelles.

Fonctionnement Technique des LLM

Les LLM reposent sur des architectures de réseaux neuronaux profonds, notamment les modèles Transformer (ou modèles auto-attentifs), capables d'apprentissage profond. Les Transformers peuvent être utilisés peuvent combiner plusieurs types de média. ChatGPT est un excellent exemple de transformer multimodal puisqu'il permet d'intégrer à ses invites de commande à la fois du texte, de l'image et du son. Les LLM issus de ces modèles Transformer sont capables de traiter des quantités massives de données textuelles pour apprendre les structures linguistiques et la sémantique. Ces modèles utilisent des mécanismes d'attention pour identifier les relations et les dépendances entre les mots, leur permettant ainsi de capturer des nuances et des contextes complexes.

Origines des LLM

Les prémices des LLM remontent seulement aux dernières années avec des avancées notables dans le domaine de l'apprentissage profond (Deep Learning) appliqué au traitement du langage naturel. Ce n'est par exemple qu'en 2017 que le modèle Transformer a été introduit. Depuis de très nombreuses applications ont vu le jour comme les outils de traductions assistés par IA tels que Google Translate ou Deepl. Plus récemment, et notamment à partir de 2022, des modèles emblématiques tels que ChatGPT (Generative Pre-trained Transformer), conçu par OpenAI, ont marqué une étape majeure dans le développement de ces technologies.

Utilité des LLM

La polyvalence des LLM se reflète dans leur utilisation diversifiée : de la génération de texte automatique à la traduction multilingue en passant par l'analyse de sentiment, l'assistance virtuelle et la génération de résumés automatiques. Ces modèles offrent des solutions innovantes pour de nombreuses applications et sont devenus un pilier crucial de l'intelligence artificielle conversationnelle. Par exemple, ils servent à alimenter des chatbots et des assistants virtuels pour des interactions humaines simulées, fournissant des informations ou répondant à des requêtes ou bien à proposer des corrections grammaticales et améliorer le style d'écriture pour rendre le texte plus clair et plus professionnel.

Éditeurs de Solutions LLM

Plusieurs acteurs majeurs sont impliqués dans le développement et l'exploitation des LLM. Des entreprises telles qu'OpenAI, entreprise de recherche en intelligence artificielle (IA) fondée en décembre 2015 par Elon Musk (fondateur de Tesla et SpaceX), Sam Altman (ancien président d'Y Combinator, incubateur de start-ups), Greg Brockman (ancien directeur de Stripe) et Ilya Sutskever (chercheur en intelligence artificielle reconnu), Google, Microsoft, Amazon et d'autres grands noms de la technologie ont investi des ressources considérables dans la recherche et le déploiement de ces modèles afin d'améliorer leurs produits et services basés sur le langage.

Cas d'Usage des LLM

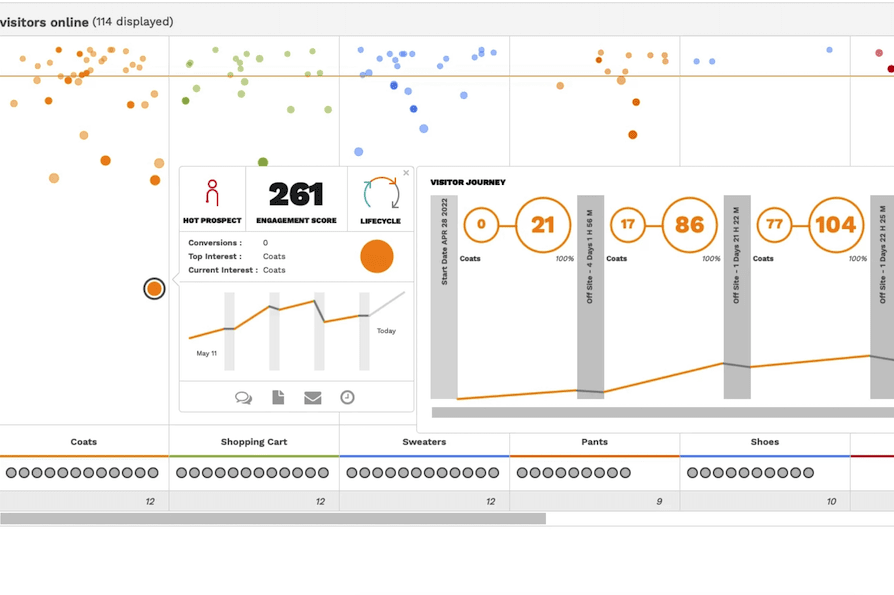

Les LLM trouvent des applications concrètes dans un large éventail de domaines. Ils sont cependant historiquement utilisés pour la traduction de manière automatique en langage naturel. Contrairement aux anciens traducteurs en ligne utilisant des RNN (Recurrent Neural Network ou réseaux neuronaux récurrents), les traducteurs modernes basés sur des Transformers ont la capacité de lier les mots entre eux. Cela leur permet d'obtenir des tournures de phrase beaucoup plus proches du langage naturel écrit ou parlé, et de donner le bon sens à un mot qui peut en avoir plusieurs. Les LLM sont aussi utilisés pour la création de contenu optimisé pour le SEO, l'analyse de données textuelles pour prendre des décisions commerciales éclairées (rapports de gestion, plans stratégiques, etc), la personnalisation de l'expérience utilisateur (assistance en ligne), le développement informatique (les LLM apprenant aussi le code informatique) ou bien encore dans le secteur médical pour l'analyse de documents et de recherches et quantité d'autres applications impossibles à lister de manière exhaustive.

Quelle est la différence entre ChatGPT et un LLM ?

GPT n'est que la couche de LLM de ChatGPT. Ce dernier se décompose en cinq couches. Tout d'abord il y une première couche d'embedding non-supervisé pour vectoriser les mots. La vectorisation d'un mot dans un modèle de langage est une technique qui mappe les mots ou les phrases d'un vocabulaire à un vecteur correspondant de nombres réels. Cette "vectorisation" capture les propriétés sémantiques des mots, préservant le contexte linguistique dans un format mathématique qui peut être traité par les modèles d'IA. Les valeurs du vecteur représentent la fréquence à laquelle chaque mot apparaît dans un passage de texte donné. Ensuite vient l'apprentissage auto-supervisé pour le traitement du langage. C'est là que se situe la technologie des Transformers et le LLM en tant que tel. A ces deux premières couches s'ajoute un mode d'entrainement supervisé qui permet d'apprendre au bot à répondre aux questions sur la base de grands ensembles de données. Cette troisième couche permet que non seulement les mots alignés aient un sens (ce qui est la mission des Transformers), mais aussi de gérer des scénarios complexes : répondre à une question, converser en mode chatbot, résumer un texte, etc. Enfin, 5ème couche, l'apprentissage par renforcement consiste à soumettre les réponses fournies par ChatGPT à des experts humains qui leur attribuent une note. Sur la base de cette notation, le modèle affine la pertinence de ses résultats.